El análisis de vulnerabilidades con Big Data aplica técnicas avanzadas de procesamiento masivo para identificar debilidades que no son visibles mediante enfoques tradicionales. Al correlacionar grandes volúmenes de datos procedentes de registros de sistemas, tráfico de red, configuraciones, activos digitales y fuentes no estructuradas, se construye una visión técnica completa de la superficie de ataque. Este modelo permite detectar patrones de exposición, relaciones indirectas entre activos y condiciones de riesgo que permanecen ocultas cuando los datos se analizan aisladamente.

La integración de analítica avanzada y modelos de aprendizaje automático transforma este análisis en un proceso continuo y orientado a riesgo real. Las vulnerabilidades dejan de evaluarse únicamente por su severidad teórica y pasan a priorizarse según contexto operativo, criticidad del activo y probabilidad de explotación. Este enfoque reduce falsos positivos, mejora la eficiencia de los equipos de seguridad y refuerza la capacidad de anticipación frente a amenazas en entornos distribuidos y altamente dinámicos.

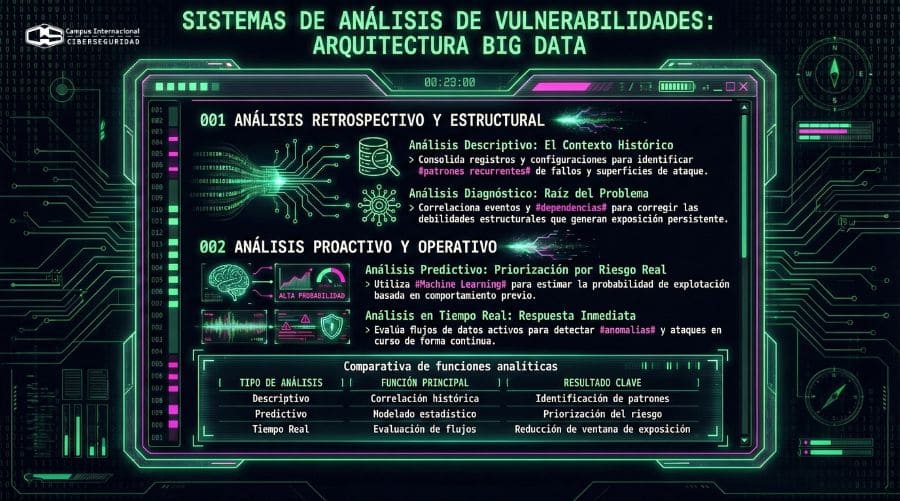

4 Tipos de análisis de vulnerabilidades realizados con Big Data

El análisis de vulnerabilidades con Big Data se apoya en distintos enfoques analíticos que permiten evaluar el riesgo desde perspectivas técnicas complementarias. Cada uno cumple una función específica dentro del proceso y aporta información distinta para la toma de decisiones en ciberseguridad.

- Análisis descriptivo: Consolida datos históricos procedentes de registros, configuraciones y eventos de seguridad. A través de su correlación, identifica patrones recurrentes de fallos, exposiciones repetidas y superficies de ataque mal controladas. Este enfoque aporta contexto técnico y permite entender cómo evoluciona el riesgo dentro del entorno.

El análisis de vulnerabilidades con Big Data correlaciona datos técnicos para detectar debilidades ocultas

- Análisis predictivo: Introduce modelos estadísticos y algoritmos de aprendizaje automático entrenados con grandes volúmenes de datos. Estos modelos estiman la probabilidad de explotación de una vulnerabilidad según su comportamiento previo y su contexto operativo. La priorización se orienta al riesgo real y no solo a la severidad teórica.

- Análisis diagnóstico: Profundiza en las causas técnicas que originan las vulnerabilidades detectadas. Mediante la correlación de eventos, cambios de configuración y dependencias entre sistemas, identifica los factores que generan exposición persistente. Este enfoque permite corregir debilidades estructurales y evitar su reaparición.

- Análisis en tiempo real: Evalúa flujos de datos conforme se generan dentro de la infraestructura. Detecta anomalías y comportamientos que indican explotación activa o condiciones previas al ataque. Integrado en plataformas de Big Data, reduce la ventana de exposición y mantiene un control continuo del riesgo.

Ciberseguridad en el análisis de Big Data

La ciberseguridad en el análisis de Big Data introduce controles técnicos orientados a proteger datos, procesos analíticos y resultados generados. En este contexto, la superficie de ataque se amplía debido al volumen, la variedad de fuentes y la complejidad de las arquitecturas distribuidas. Por ello, la protección no se limita al almacenamiento, sino que abarca todo el ciclo de vida del dato, desde la ingesta hasta el análisis final.

Para garantizar la integridad del análisis, se aplican mecanismos de control de acceso, cifrado en tránsito y en reposo, y segmentación de datos según su criticidad. Estas medidas reducen el impacto de accesos no autorizados y limitan la exposición de información sensible. Al mismo tiempo, la monitorización continua permite detectar patrones anómalos en el uso de los datos, reforzando la detección temprana de incidentes. De este modo, la ciberseguridad se integra como un componente estructural del análisis de Big Data, alineado con la gestión del riesgo y el cumplimiento normativo.

Integración de herramientas de ciberseguridad

La integración de herramientas de seguridad informática dentro de arquitecturas de Big Data permite un control coherente del riesgo a lo largo de todo el flujo analítico. Este proceso comienza con la selección de soluciones que cubren prevención, detección y respuesta, alineadas con la naturaleza distribuida del entorno. Firewalls, sistemas de detección de intrusiones y plataformas de respuesta a incidentes se conectan para compartir eventos y contexto operativo en tiempo casi real.

A continuación, los sistemas de correlación centralizan la información procedente de múltiples fuentes. Plataformas de gestión de eventos de seguridad consolidan registros, alertas y métricas, lo que permite identificar patrones complejos que no serían visibles de forma aislada. Esta correlación mejora la detección de comportamientos anómalos y facilita el análisis de vulnerabilidades con mayor precisión contextual.

Por otro lado, la integración con soluciones de gestión de identidades refuerza el control de acceso a datos y procesos analíticos. La autenticación multifactor y los roles granulares limitan la exposición interna y reducen el riesgo de abuso de privilegios. Este enfoque resulta crítico cuando múltiples equipos acceden a la misma infraestructura de datos.

Finalmente, la automatización y orquestación conectan estas herramientas en flujos de respuesta coordinados. La aplicación automática de parches, el aislamiento de activos comprometidos y la generación de alertas priorizadas reducen el tiempo de reacción. Así, la integración convierte la ciberseguridad en un elemento operativo del análisis de Big Data, no en un componente aislado.

Técnicas de minería de datos para identificar vulnerabilidades

Las técnicas de minería de datos permiten analizar grandes volúmenes de información con el objetivo de descubrir patrones que revelan vulnerabilidades técnicas y operativas. En primer lugar, los métodos de agrupamiento organizan eventos y comportamientos similares para identificar desviaciones relevantes. Estas desviaciones suelen indicar configuraciones anómalas, fallos recurrentes o exposiciones persistentes dentro de la infraestructura.

A continuación, los modelos de clasificación separan comportamientos normales de aquellos asociados a riesgo. Entrenados con datos históricos, estos modelos identifican combinaciones de variables que preceden a incidentes de seguridad. Este enfoque permite detectar vulnerabilidades activas en fases tempranas y facilita su priorización según impacto potencial.

Por otro lado, el análisis de regresión evalúa la relación entre múltiples factores técnicos y la aparición de fallos de seguridad. Este método identifica qué variables influyen de forma directa en la exposición al riesgo. Gracias a ello, los equipos de seguridad actuan sobre las causas reales y no solo sobre los síntomas visibles.

Finalmente, la detección de anomalías analiza flujos de datos en busca de comportamientos fuera de lo esperado. Aplicada sobre tráfico de red, accesos o ejecuciones de procesos, esta técnica señala condiciones que favorecen la explotación de vulnerabilidades. Integrada en entornos de Big Data, refuerza un análisis continuo y orientado a prevención.

Herramientas y tecnologías utilizadas en el análisis de vulnerabilidades

El análisis de vulnerabilidades con Big Data se apoya en plataformas capaces de almacenar, procesar y correlacionar información a gran escala.

- En primer lugar, las infraestructuras distribuidas permiten gestionar datos procedentes de múltiples fuentes sin pérdida de rendimiento. Estos entornos facilitan el análisis continuo de registros, configuraciones y eventos de seguridad en arquitecturas complejas.

- Sobre esta base, las herramientas de correlación y análisis centralizan la información operativa. Los sistemas de gestión de eventos de seguridad consolidan registros heterogéneos y aplican reglas analíticas para detectar patrones de riesgo. Esta capacidad es clave para identificar vulnerabilidades que emergen por la interacción entre sistemas y no por fallos aislados.

- A continuación, las tecnologías de analítica avanzada incorporan modelos estadísticos y algoritmos de aprendizaje automático. Estos modelos analizan grandes volúmenes de datos históricos y en tiempo casi real para identificar tendencias, anomalías y condiciones previas a la explotación. Su uso permite priorizar vulnerabilidades con mayor precisión y reducir el ruido generado por alertas irrelevantes.

- Por último, las herramientas de visualización transforman los resultados técnicos en información operativa comprensible. Cuadros de mando y representaciones gráficas facilitan la identificación de áreas críticas y la evolución del riesgo. Integradas correctamente, estas tecnologías convierten el análisis de vulnerabilidades en un proceso continuo, medible y alineado con la toma de decisiones técnicas y estratégicas.

Riesgos asociados al Big Data

El uso intensivo de Big Data en entornos de ciberseguridad introduce riesgos técnicos que deben gestionarse explícitamente. Por ejemplo la concentración de grandes volúmenes de información convierte las plataformas de datos en objetivos prioritarios para ataques avanzados. Una brecha en estos entornos expone no solo datos sensibles, sino también modelos analíticos, reglas de detección y conocimiento operativo crítico.

Otro riesgo relevante aparece en la calidad y gobernanza del dato. Datos incompletos, desactualizados o mal contextualizados generan análisis erróneos y priorizaciones incorrectas. Cuando estos datos alimentan modelos automáticos, el error se propaga y afecta directamente a la toma de decisiones defensivas. Sin controles estrictos, el Big Data amplifica el impacto del fallo en lugar de mitigarlo.

También existen riesgos asociados a la privacidad y el cumplimiento normativo. El tratamiento masivo de información personal exige mecanismos sólidos de control, anonimización y trazabilidad. La falta de alineación con marcos regulatorios expone a la organización a sanciones y pérdida de confianza, especialmente cuando los datos proceden de múltiples fuentes y jurisdicciones.

Por último, la dependencia excesiva de automatismos analíticos introduce un riesgo operativo. Sin supervisión experta, los modelos pierden contexto y pueden ignorar amenazas emergentes o generar falsas sensaciones de seguridad. Por ello, el Big Data exige perfiles capaces de entender tanto la tecnología como el riesgo real. Esta combinación de competencias técnicas, analíticas y defensivas es precisamente la que se desarrolla en el Máster en Ciberseguridad, una formación orientada a profesionales que buscan dominar el análisis avanzado de vulnerabilidades y la protección de infraestructuras críticas desde una perspectiva integral y actualizada.